Google anuncia que BERT se globaliza, ampliando su alcance a más de 70 idiomas en todo el mundo, incluido el español. Aquí puedes ver dónde está operativo BERT

BERT, la mayor actualización del algoritmo de Google en 5 años, permitirá comprender mejor la intención de búsqueda de los usuarios en consultas que dependen del contexto.

BERT = Bidirectional Encoder Representations from Transformers

Usando Inteligencia Artificial y aprendizaje automático para proporcionar respuestas más relevantes, se calcula que BERT alterará la clasificación en el 10% de los resultados de búsqueda de Google.

Según el artículo Understanding searches better than ever before, publicado el 25 de octubre de 2019 en el blog de Google por Pandu Nayak, vicepresidente del departamento de búsqueda de Google, BERT ayuda a comprender mejor 1 de cada 10 búsquedas.

En sus propias palabras, la comprensión del lenguaje gracias a este algoritmo de aprendizaje automático está permitiendo una mejora significativa en la forma en que Google entiende las consultas, lo que representa...

"...el mayor avance en los últimos cinco años, y uno de los mayores avances en la historia de la búsqueda."

A continuación puedes ver las respuestas a las preguntas más frecuentes sobre BERT:

Qué es BERT?

El anuncio del lanzamiento de BERT fue publicado en la cuenta oficial de Google en Twitter:

Meet BERT, a new way for Google Search to better understand language and improve our search results. It's now being used in the US in English, helping with one out of every 10 searches. It will come to more counties and languages in the future. pic.twitter.com/RJ4PtC16zj

— Google SearchLiaison (@searchliaison) 25 de octubre de 2019

BERT, abreviatura de Bidirectional Encoder Representations from Transformers, es una técnica de representación del lenguaje basada en arquitectura de redes neuronales para el Procesamiento del Lenguaje Natural (PNL) que permite entrenar un sistema de respuesta a preguntas de última generación o conversacionales.

En otras palabras, BERT ayuda al resto de algoritmos de Google para comprender mejor el lenguaje natural utilizado por las personas.

Este nuevo algoritmo no sustituye a otros algoritmos existentes como Rankbrain, sino que trabaja en colaboración con los demás.

El objetivo es mejorar el entendimiento de las búsquedas que realizan los usuarios, relacionando cada una de las palabras de una frase con el resto, para comprender la forma en que se expresan las personas y ofrecer resultados de búsqueda más precisos y acertados.

BERT considera el contexto completo de cada palabra observando las anteriores y posteriores, para comprender la intención de las consultas de búsqueda

BERT supera a los métodos anteriores porque es el primer sistema sin supervisión para el Procesamiento del Lenguaje Natural (PNL), lo cual es importante porque una gran cantidad de datos de texto sin formato está disponible públicamente en la web en muchos idiomas.

Algunos de los modelos que se pueden construir con BERT son tan complejos que superan los límites del hardware tradicional, por lo que, por primera vez, Google está utilizando los últimos TPU en la nube para servir resultados de búsqueda y obtener información más relevante rápidamente.

Este avance es el resultado de la investigación de Google durante el último año sobre transformadores: modelos que procesan palabras en relación con todas las otras palabras en una oración, en lugar de una por una en orden.

Si te interesa el tema, puedes consultar información más en profundidad en el repositorio de Github y en la página de Cornell University.

A continuación puedes ver la charla (en inglés) "Deep Learning for Solving Important Problems" de

Todo el vídeo es tremendamente interesante, pero puedes ir directamente al minuto 20 si solo quieres ver la parte en la que habla sobre BERT.

Cómo afecta BERT al SEO?

Las implicaciones para el SEO son evidentes puesto que los modelos BERT se aplicarán tanto a las consultas como a la clasificación en las búsquedas de Google y a los fragmentos destacados, es decir, que alterará el orden y aspecto en que aparecen los resultados cuando se hace una búsqueda.

La afirmación de que este es el mayor avance en los últimos 5 años parece aludir al lanzamiento de Rankbrain en 2015, el primer precedente de uso de inteligencia artificial por parte de Google para comprender las consultas de los usuarios.

En sus inicios RankBrain afectaba al 15% de las búsquedas que se realizaban en inglés, pero ahora está presente en todas las búsquedas que se realizan en Google, interviniendo en la mayoría de ellas.

Por su parte BERT va más allá, permitiendo mejorar la comprensión de las consultas que recibe Google en función del contexto para devolver resultados más relevantes, lo que permitirá a los usuarios realizar consultas con un lenguaje más natural.

La complejidad de este nuevo algoritmo supera los límites del hardware convencional, por lo que quizá su lanzamiento esté relacionado con la noticia de que Google ha alcanzado la Supremacía cuántica utilizando un procesador superconductor programable.

Google calcula que el nuevo algoritmo mejorará la comprensión de una de cada diez consultas en cuestiones de clasificación, y este porcentaje irá aumentando paulatinamente como en el caso de Rankbrain.

Para profundizar en las implicaciones que tendrá BERT puedes leer este fantástico artículo (en inglés): Algorithm analysis in the age of embeddings de AJ Kohn en noviembre de 2018.

SEO para BERT

Todavía es pronto para hacer conjeturas, pero habrá que estar atentos para estudiar cómo afecta BERT al posicionamiento de cada web en las próximas semanas.

No estamos hablando solo de que habrá fluctuaciones en las posiciones de las SERPS, sino que muchos resultados dejarán de mostrarse para consultas en las que BERT decida que no son relevantes, y aparecerán otros en su lugar.

Teniendo en cuenta la irrupción de las búsquedas por voz mediante asistentes virtuales, en las que Google solo devuelve una respuesta, parece claro que en un futuro cercano la primera posición de las SERPs se llevará casi todas las visitas.

En cuanto a la posibilidad de optimizar SEO para BERT, no parece posible hacerlo más allá de procurar escribir para las personas y no para los algoritmos.

En este momento Google entiende la intención de búsqueda del usuario y dispone de la capacidad para responder con la información más relevante, por lo que el resto de "señales" que usaba hasta ahora irán perdiendo importancia con el tiempo.

Dónde está operativo BERT?

BERT comenzó a estar operativo la última semana de octubre 2019 en inglés en Estados Unidos y ahora se ha extendido a más idiomas y países para mejorar las búsquedas en todo el mundo.

Según los cálculos de Google, inicialmente BERT solo se usaba en el 10% de las consultas en inglés en Estados Unidos, por lo que el impacto inicial podía ser menor que el de una actualización de algoritmo a gran escala.

En cualquier caso este primer paso no era una excepción, sino que marca con claridad el camino para el SEO en los próximos años.

Una característica de los sistemas de Inteligencia Artificial es que pueden tomar como base los aprendizajes de un idioma y aplicarlos a otros, por lo que BERT usa modelos de aprendizaje de las mejoras en inglés para aplicarlos al resto de idiomas.

Así, Google ha estado utilizando un modelo BERT para mejorar los fragmentos destacados en los países donde esta función estaba disponible, observando mejoras significativas en algunos idiomas como coreano, hindi y portugués.

En diciembre de 2019, Google anuncia que ha ampliado el alcance de BERT a todo el mundo en más de 70 idiomas, incluido el español:

BERT, our new way for Google Search to better understand language, is now rolling out to over 70 languages worldwide. It initially launched in Oct. for US English. You can read more about BERT below & a full list of languages is in this thread.... https://t.co/NuKVdg6HYM

— Google SearchLiaison (@searchliaison) December 9, 2019

La lista de idiomas en los que BERT está operativo es larga:

BERT is rolling out for: Afrikaans, Albanian, Amharic, Arabic, Armenian, Azeri, Basque, Belarusian, Bulgarian, Catalan, Chinese (Simplified & Taiwan), Croatian, Czech, Danish, Dutch, English, Estonian, Farsi, Finnish, French, Galician, Georgian, German, Greek, Gujarati.... (MORE)

— Google SearchLiaison (@searchliaison) December 9, 2019

Y sigue...

Hebrew, Hindi, Hungarian, Icelandic, Indonesian, Italian, Japanese, Javanese, Kannada, Kazakh, Khmer, Korean, Kurdish, Kyrgyz, Lao, Latvian, Lithuanian, Macedonian

— Google SearchLiaison (@searchliaison) December 9, 2019

Malay (Brunei Darussalam & Malaysia), Malayalam, Maltese, Marathi, Mongolian, Nepali, Norwegian, Polish.... (MORE)

Y sigue...

Portuguese, Punjabi, Romanian, Russian, Serbian, Sinhalese, Slovak, Slovenian, Swahili, Swedish, Tagalog, Tajik, Tamil, Telugu, Thai, Turkish, Ukrainian, Urdu, Uzbek & Vietnamese.

— Google SearchLiaison (@searchliaison) December 9, 2019

Pero deja lo mejor para el final!

And yes, Spanish!

— Google SearchLiaison (@searchliaison) December 9, 2019

Ejemplos de BERT en búsquedas de Google

Gracias al aprendizaje automático, BERT mejora la forma en que Google entiende las búsquedas más conversacionales o aquellas en las que las preposiciones como 'para' o 'a' importan mucho en el significado.

El propio Pandu Nayak, vicepresidente de Google Search, dio un ejemplo en un evento de prensa usando la pregunta: “How old was Taylor Swift when Kanye went on stage?” (¿Cuántos años tenía Taylor Swift cuando Kanye subió al escenario?)

Sin usar BERT, Google mostraba videos del evento de 2009 durante el cual el rapero interrumpió el discurso de aceptación de la estrella del pop en los MTV Video Music Awards.

Sin embargo usando BERT, Google devuelve como primer resultado un fragmento de un artículo de la BBC, que dice: “A 19-year-old Swift had just defeated Beyoncé to win Best Female Video for her country-pop teen anthem You Belong With Me.”, resaltando "19-year-old" para enfatizar la respuesta a la pregunta.

BERT no es perfecto

En el mismo evento, Nayak también reconoció que hay áreas en las que BERT no ayuda bien.

En un ejemplo, para la búsqueda "tartán", BERT promovió los resultados del diccionario porque es una tecnología que se centra únicamente en el texto.

En las búsquedas previas a BERT, el buscador mostraba imágenes de tela de tartán, que es un resultado más convincente.

Un portavoz de Google dijo que el problema del tartán se corrigió antes del lanzamiento de BERT.

En otro caso, cuando uno busca "¿Qué estado está al sur de Nebraska?" BERT muestra la página de Wikipedia para el sur de Nebraska, en lugar del resultado ideal, que sería la página de Wikipedia para Kansas.

Evaluación de BERT

A continuación tienes algunos de los ejemplos que muestran el proceso de evaluación de Google para demostrar la capacidad de BERT para comprender la intención de búsqueda, detectando los sutiles matices del lenguaje que las máquinas no comprenden como los humanos.

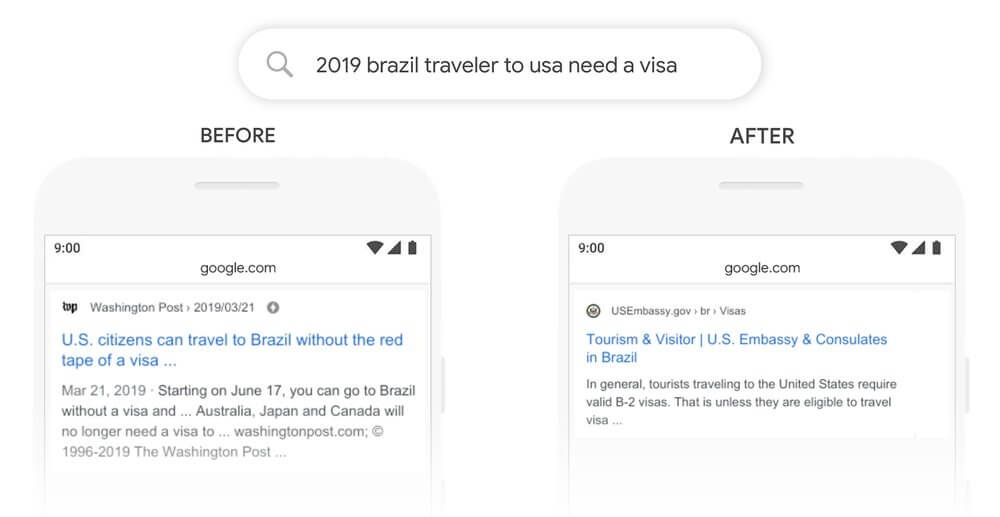

2019 brazil traveler to usa need a visa

En la búsqueda "2019 brazil traveler to usa need a visa", BERT ayuda a Google a comprender que la consulta "2019 El viajero de Brasil a EEUU necesita una visa" es sobre un brasileño que viaja a los Estados Unidos, y no al revés.

En la imagen, el resultado "Before" demuestra que los algoritmos de Google no entendían la importancia de esta conexión y devolvían resultados sobre ciudadanos estadounidenses que viajan a Brasil.

En el resultado "After" ofrecido por BERT, la palabra "a" y su relación con las otras palabras en la consulta son particularmente importantes para comprender el significado y ofrecer un resultado mucho más relevante para esta consulta.

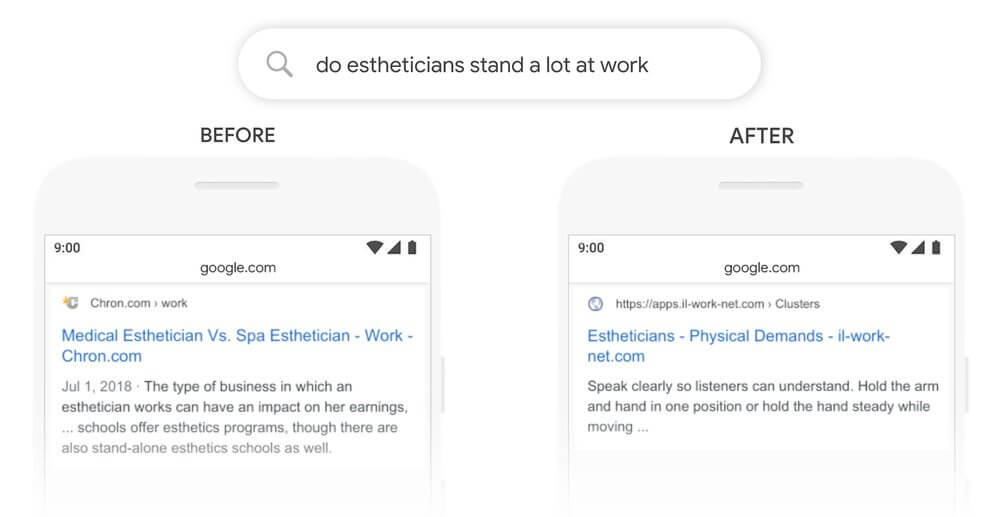

Do estheticians stand a lot at work?

En la consulta "¿do estheticians stand a lot at work?", Google interpretaba la palabra "stand" en el sentido de "stand alone", lo que devuelve resultados de búsqueda irrelevantes.

Usando BERT Google puede interpretar mejor cómo se usa la palabra y comprender que la consulta "Por qué los esteticistas trabajan mucho?" está relacionada con las demandas de trabajo como esteticista, para mostrar una respuesta más útil.

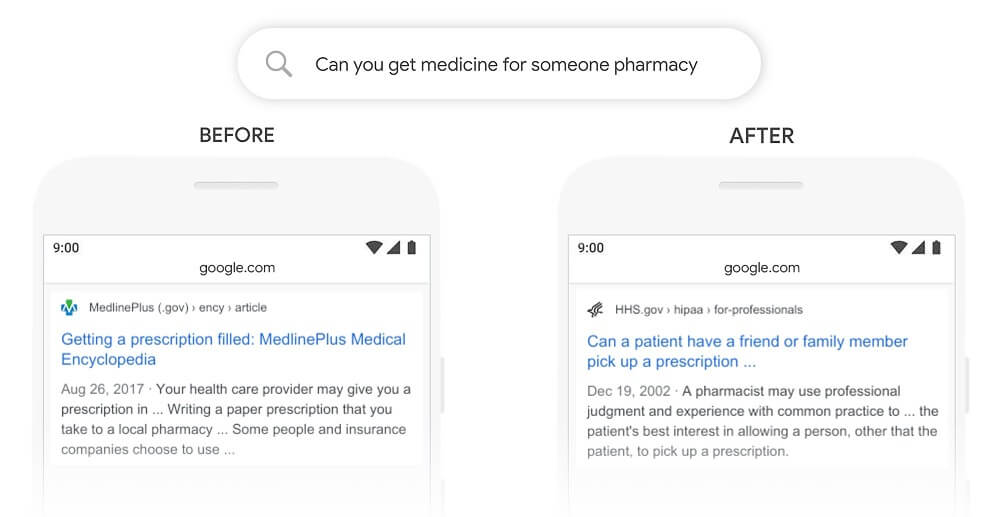

Can you get medicine for someone pharmacy

En la consulta "Can you get medicine for someone pharmacy", "¿Puedes conseguir medicamentos para alguien en una farmacia?" el modelo BERT entiende que "for someone" es una parte importante de esta consulta, mientras que anteriormente los resultados son generales sobre recetas médicas.

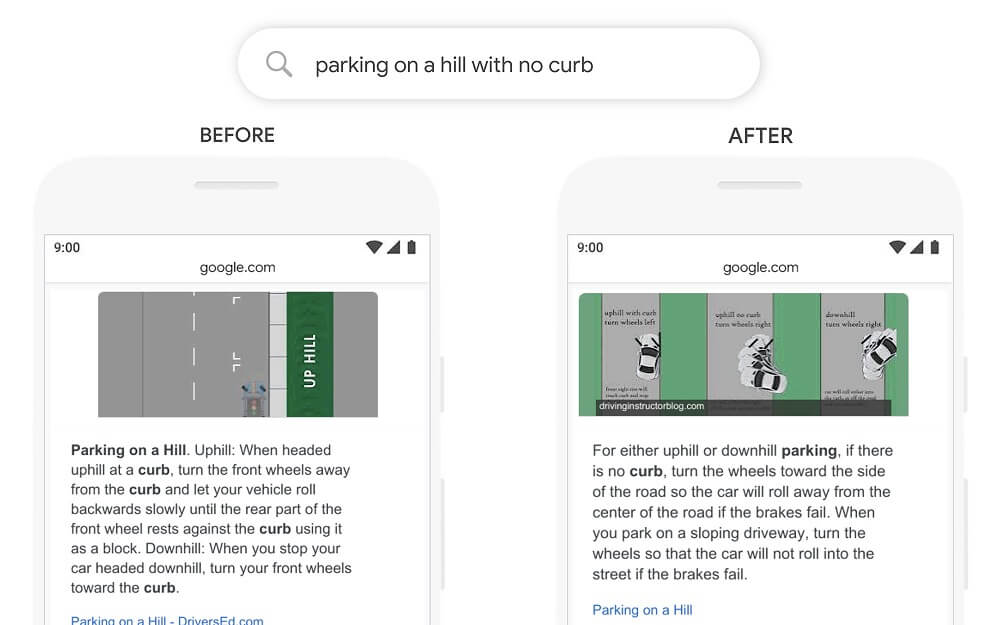

Parking on a hill with no curb

Una consulta como "parking on a hill with no curb", que muestra fragmentos destacados en la respuesta, confundía a los algoritmos de Google porque daba demasiada importancia a la palabra "curb" y podía ignorar la palabra "no", sin entender lo crítica que era esa palabra para responder adecuadamente la consulta.

En el ejemplo, la consulta "estacionamiento en una colina sin bordillo" devolvía los resultados de estacionamiento en una colina con una acera.

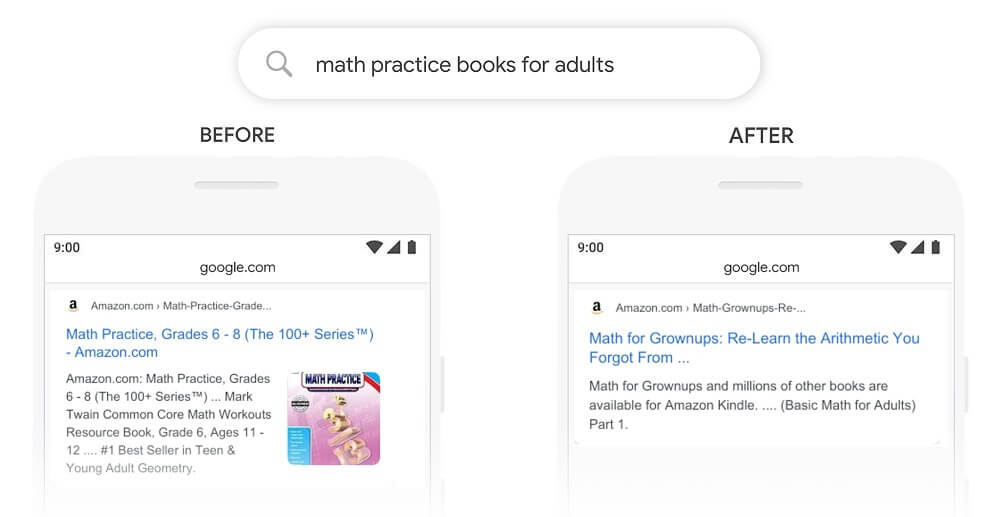

Math practice books for adults

Consultando "math practice books for adults", “Libros de práctica matemática para adultos”, la página de resultados anterior incluía un libro en la categoría “Adulto joven”, mientras BERT puede comprender mejor que “adulto” está fuera de contexto y elegir un resultado más útil.